分身术来了,苹果发表 AI 新技术,30 分钟打造你的「数字分身」

当一众科技巨头在生成式 AI 赛道打得火热时,一旁的苹果却显得有些静默。而今天苹果发布了一篇生成式 AI 的研究论文,难得向我们展示了他们在这一领域的最新突破。这篇论文详细介绍了一项名为 HUGS(Human Gaussian Splats)的生成式 AI 技术。简言之,得益于这一技术的加持,我们甚至可以通过一段短视频来打造一个人类的「数字化身」。言归正传,让我们来看看具体的演示效果

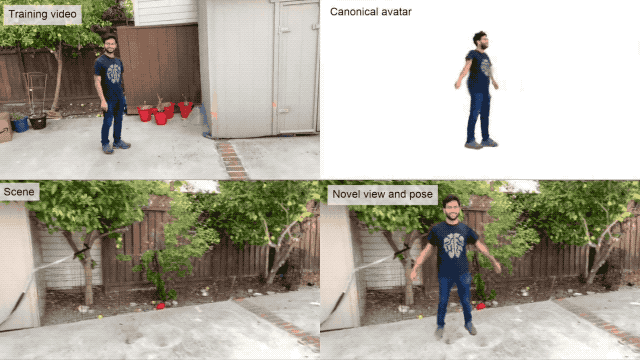

据苹果官方介绍,这些年来,虽然基于神经网络的渲染技术在训练和渲染速度上取得了显著的提升,但该技术主要集中于静态场景的摄影测量,难以应用到灵活运动的人类模型上。为了解决这个问题,苹果机器学习研究中心和马克斯·普朗克智能系统研究所合作,提出了一种名为 HUGS 的 AI 框架,经过训练后的 HUGS 能够在 30 分钟内,自动从视频中分离出静态背景和一个完全动态变化的数字化身。

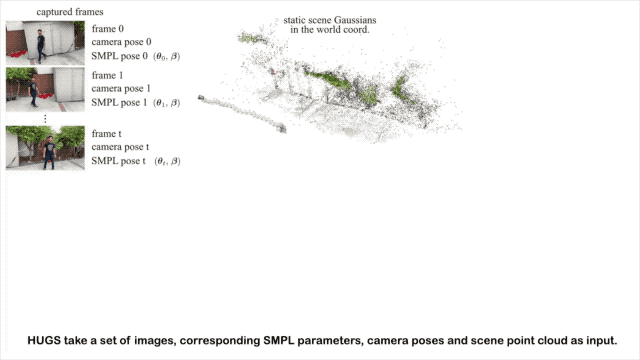

具体是怎么做到的呢?他们的核心思路是用三维高斯分布(3DGS)来表示人和场景。你可以将高斯分布(GS)理解成一个带有中心位置、体积大小、旋转角度的参数化的三维钟形体。如果我们在一个房间的不同位置放很多这种三维钟形体,调整它们的位置、大小、角度,组合在一起就可以重建出房间的结构和场景中的人了。

高斯分布训练和渲染起来非常快,这也是这个方法最大的优势。接下来面临的问题是,高斯分布本身相对简单,仅仅堆叠在一起很难精细地模拟出人体复杂的结构。

因此,他们首先使用了一个叫做 SMPL 的人体模型,这是一个常用的、相对简单人体形状模型,为高斯分布提供了一个起始点,锚定了人体的基本形状和姿势。

尽管 SMPL 模型提供了基本的人体形状,但它在处理一些细节,比如衣服褶皱、发型等方面并不是很准确,而高斯分布可以在一定程度上偏离和修改 SMPL 模型。这样,他们能够更灵活地调整模型,更好地捕捉和模拟这些细节,并使得最终的数字化身具有更加真实的外观。

分开只是第一步,还需要让构建的人体模型动起来。为此,他们设计了一个特殊的变形网络,学习控制每个高斯分布(表示人体和场景的形状)在不同骨骼姿势下的运动权重,也就是所谓的 LBS 权重。这些权重告诉系统,当人体骨骼运动时,高斯分布应该如何跟随着变化,以模拟出真实的运动。

此外,他们不仅仅停留在设计网络,还通过观察真实的人类运动视频对数字化身的高斯分布、场景的高斯分布和变形网络进行了优化。这样,数字化身就能更好地适应不同的场景和动作,使其看起来更加真实。相比于传统的方法,这种方法的训练速度显著提高,至少快了 100 倍,而且它还能渲染每秒 60 帧的高清视频。

更重要的是,这种新方法实现了更高效的训练过程和更低的计算成本,有时仅仅需要 50-100 帧的视频数据,相当于短短 2-4 秒的 24 帧视频。对于这一成果的发布,网友们的态度却呈现两极分化的趋势。数码博主 @mmmryo 惊叹于生成模型对皮肤和衣服、头发等细节的建模,并猜测这项技术很有可能是为 iPhone 或 Vision Pro 而专门设计的。

三星科学家 Kosta Derpani 现身苹果研究员 Anurag Ranjan 的评论区,对这项成果表达了充分的赞美与肯定。

苹果宣布将会放出模型的代码,但截至发稿前,点击苹果官方给予的代码链接只会得到「404」。

值得一提的是,这篇论文的作者出现了熟悉的华人面孔。论文核心作者 Jen-Hao Rick Chang (张仁豪)来自于中国台湾。在 2020 年加入苹果之前,他曾在卡内基梅隆大学 ECE 系获得了博士学位。张仁豪的学术生涯颇具传奇色彩,在卡内基梅隆大学期间,他师从图像处理领域大神 Vijayakumar Bhagavatula 教授和 Aswin Sankaranarayanan 教授。

在前三年致力于机器学习领域之后,出于研究兴趣,张仁豪毅然调转研究方向,开始深入探究截然不同的光学领域,此后陆续在计算机图形学和交互技术领域的 SIGGRAPH,以及机器学习领域 ICML 国际学术会议上发表多篇力作。而苹果的这篇论文便是他合著的最新研究成果,最后放上这篇论文的具体地址,更多具体细节可在下方链接查阅👇

https://arxiv.org/abs/2311.17910不得不说,今年的 AI 视频生成赛道简直是卷无人性,Runway 的出现让生成式 AI 步入了电影神圣的殿堂,由 Runway 技术支持的《瞬息全宇宙》将 AI 视频生成的魔力展现得淋漓尽致。

随后 Pika Lab 的 Pika 1.0 将 AI 视频生成的「专利」从专业创作者的手中抢了回来。通过更简单的文本输入、浅显易懂的视频编辑,更高质量的视频生成,让每个人都有机会成为自己的视频导演。不论你是专业者还是业余者,也都能利用 MagicAnimate 人体动画生成器来自娱自乐。

只需按照预定的动作序列输入人物图片,就能生成动态视频。动起来的主角,可以是你的自拍、宠物,也可以是一张熟悉的名画,发挥你的奇思妙想之后,万物皆可动。

当然,更引人注目的可能是今天 Google 团队推出的视频生成模型 VideoPoet,支持各种视频生成功能以及音频生成,甚至还能让大模型来指导完整的视频生成。不仅一次能够生成 10 秒超长视频,VideoPoet 还能解决现在无法生成动作幅度较大的视频难题,妥妥属于视频生成届的全能选手,唯一的缺点可能就是「活在」Google 的博客里。

相对而言,苹果这个最新成果则瞄准了当下类似于 AI 主播的热门技术,一段可能不到几秒的短视频就能生成你的「数字化身」,眼见不一定为实,未来如何证明「我即是我」或许又值得发愁了。明年 Vision Pro 即将在美国发售,而这项论文的研究成果该不会是提前埋下的彩蛋吧。