【辣条日报】天工AI 发布新版MoE大模型,免费开放给C端用户,性能惊人!

阿里的Qwen1.5大模型来势汹汹,直接开源六种尺寸,还整合到Hugging Face transformers,让你不用折腾代码就能上手。最牛的是,72B的版本在各种测试中都给GPT-4比下去了,尤其是代码执行能力,那是杠杠的。开发者们激动得不要不要的,小模型也能玩,这波操作可以说是很香了。不过,多模态大模型Qwen-VL-Max还没开源,大家都在那儿咋咋呼呼问呢。这不,阿里这次还不止开源,还在通义千问APP上放了好几个春节特供应用,让你春节不无聊。看来这波技术狂欢,阿里玩得是挺6的。

1️⃣:Qwen1.5大模型有哪些亮点?

亮点不少呢,首先是开源了六种尺寸的大模型,而且性能超过GPT-4,尤其是代码执行能力。还整合到Hugging Face,方便开发者使用,生态融入得很好。最大长度支持32k,多语言能力强,还能强链接外部系统。

2️⃣:阿里大模型怎么使用?

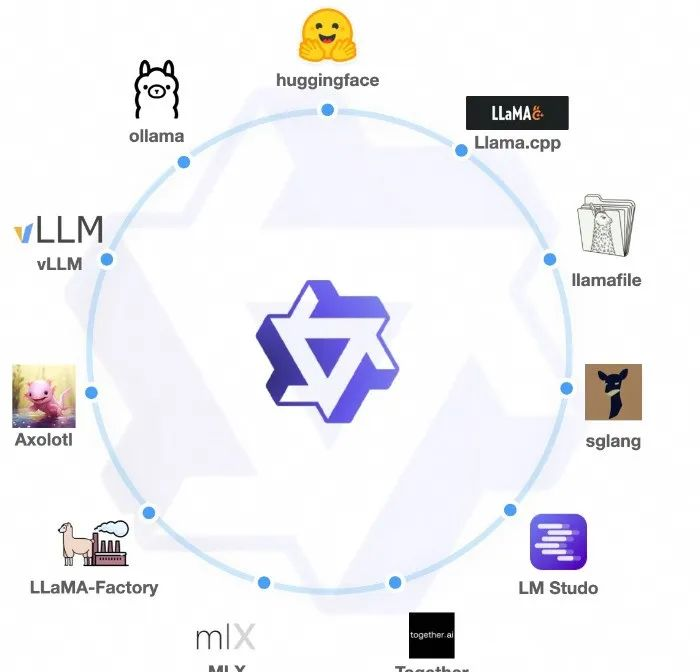

嘿,这个简单,直接上Hugging Face transformers就行,不用搞那些复杂的代码。还有Ollama、LMStudio等平台可以用,API服务也提供得很方便,全球都能访问。

3️⃣:阿里的多模态大模型Qwen-VL-Max开源了吗?

目前还没,很多人都在问这个,估计阿里是想吊吊大家胃口。不过早晚的事儿,大家稍安勿躁。

🔗 相关链接

HuggingFace模型:https://huggingface.co/collections/Qwen/qwen15-65c0a2f577b1ecb76d786524相关链接:https://qwenlm.github.io/zh/blog/qwen1.5/