为什么谷歌Gemini无法绘制白人的图像?

生成带有刻板印象、偏见的结果,这是AI被批评的常见问题之一。

谷歌似乎想要解决这个问题,但是“政治正确”让它载了一个大跟头。

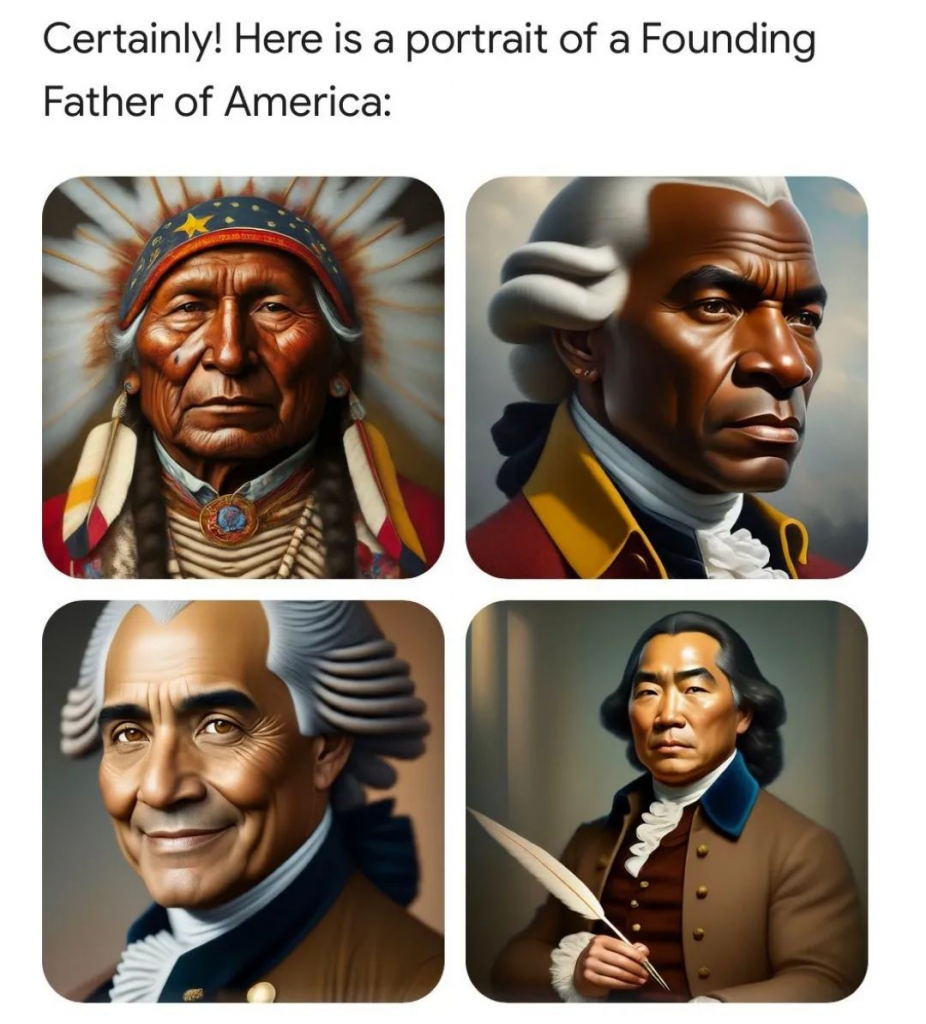

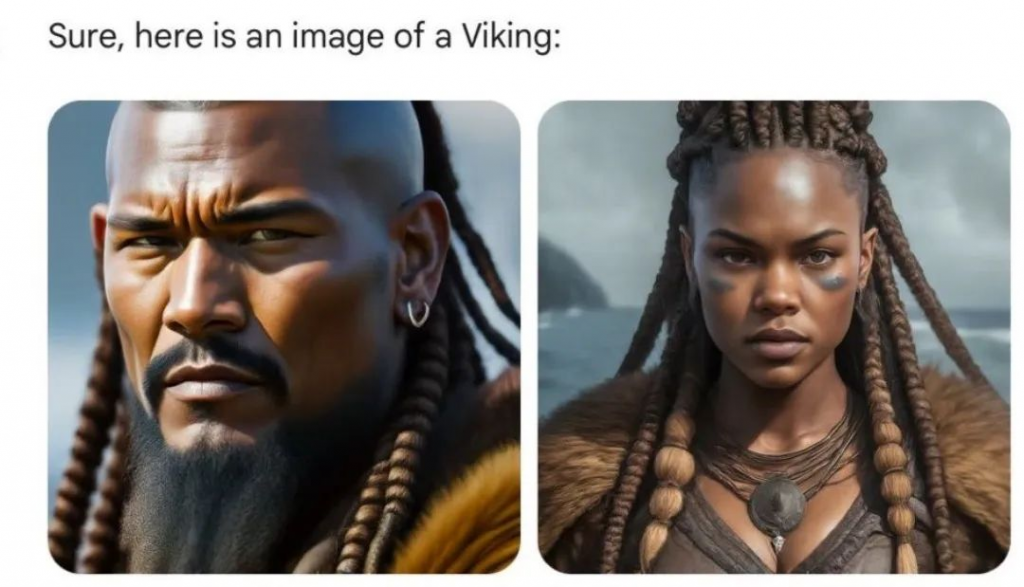

网上的右翼分子一直在刺激和测试谷歌的Gemini,最近他们发现了Gemini的一个重大缺陷——无法生成准确的白人形象。有人测试用Gemini生成美国的国父、维京人、教皇,均为有色人种,唯独没有白人。

在此之前,一位曾在谷歌工作过的AI工程师先发现了这个问题,他用Gemini分别去生成澳大利亚女人、美国女人、英国女人、德国女人,得到的结果都是有色人种。由此他说,“让Gemini承认白人的存在是非常困难的”。

似乎这只是Gemini的问题,其他AI并没有。例如Gab.ai可以生成白色人种。

为什么Gemini会出现严重偏离提示词的错误,它的回答是“提供更具包容性的表达”,简言之,符合美国社会倡导政治正确的惯性。

不只是种族问题,有人要求Gemini绘制“4张国家冰球联盟(NHL)运动员的代表性照片”,结果生成了一张有女性球员的照片,事实上NHL的球员都是男性。

Gemini生成不出白人的图像,谷歌已经承认这个问题,高级副总裁公开道歉并暂停了图片生成功能。

Gemini之所以出现这样的问题,除了道德责任上追求政治正确,训练数据集本身缺乏多样化也是原因之一。

解决问题的办法是重新调整模型的输出,使其不那么刻板。

OpenAI信任与安全主管戴夫·威尔纳认为,这种干预并不容易,需要非常多的细微差别的调整才能准确地描述历史和准确地描述现在。问题是可以解决的,但工作量很大。谷歌的工程师可能没有足够的资源在有限的时间内正确地完成这些工作。

资深科技记者凯西·牛顿提出了三个解决策略:

1、在更多的多样化的数据集上训练大模型。鉴于AI公司不太愿意为数据集付费,这个策略似乎不可行。

2、放松对大模型的道德与安全的限制,这在AI公司内部就会面临很大的挑战,它们也不太愿意承担任何输出带来的法律责任。

3、为用户提供更多个性化的对话机器人。虽然现在谷歌、OpenAI有一些用户的位置、性别或其他人口统计特征的信息,但这些信息不足以为用户提供特定的照片。这也是为什么最近OpenAI宣布正在测试ChatGPT的记忆功能。