每一次重大的技术革命都伴随着一波学习浪潮,直到我们对这些新的词汇变得非常熟悉。对于下一个主要的技术浪潮(人工智能)而言,亦是如此。当所有人在考虑这种新兴技术可能带来的风险和好处时,理解人工智能的术语将至关重要。在过去几年中,出现了许多与人工智能相关的新术语,比如 “大语言模型”、“提示工程”等。

为了能够跟上时代的步伐,我们整理了一系列需要熟悉的名词,以便我们更加了解人工智能如何改变我们的世界。

通用人工智能(Artificial general intelligence ,AGI)

AGI中文翻译为通用人工智能,又称为强人工智能。AGI是一种具有与人类相同的思维的人工智能,甚至也有意识,具备数字思维的能力。OpenAI和DeepMind等公司已经明确表示,创造AGI是他们的目标。OpenAI认为,它将“通过增加财富、加速全球经济、协助发现新的科学知识来帮助全人类提升”,并成为“人类聪明才智和创造力的强大助力”。

对齐(Alignment)

人类从未与强大的非人类智慧生物共享地球。如何确保人工智能的价值观与人类的价值观保持一致?

这种一致性问题加剧了人们对人工智能灾难的担忧。7月初, OpenAI宣布了一项“超级对齐”计划,旨在确保人工智能系统遵循人类的意图。

偏见(Bias)

为了让人工智能达到预期效果,它需要通过人类提供的数据集进行学习。但是,人类很难没有偏见。如果人工智能从一个有偏差的数据集获得能力,例如,与种族或性别有关的数据,那么它就有可能产生不准确的、令人反感的输出。随着人们赋予人工智能越来越多的把关和决策职能,许多人担心机器可能会产生一些潜在偏见,阻止部分人群获得某些服务或知识。

计算(Compute)

计算指的是训练人工智能所需的计算资源,比如处理能力。它可以被量化,所以它是衡量人工智能发展速度的一个指标(以及人工智能的成本和强度)。

自2012年以来,计算量每3.4个月翻一番,这意味着,当OpenAI的GPT-3在2020年接受训练时,它需要的计算能力是2012年最先进的机器学习系统之一的60万倍。

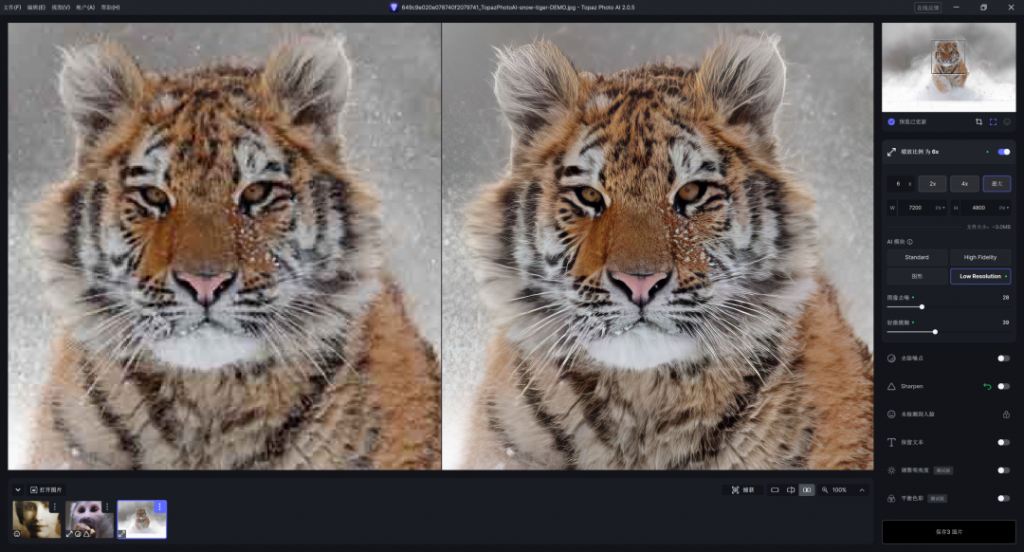

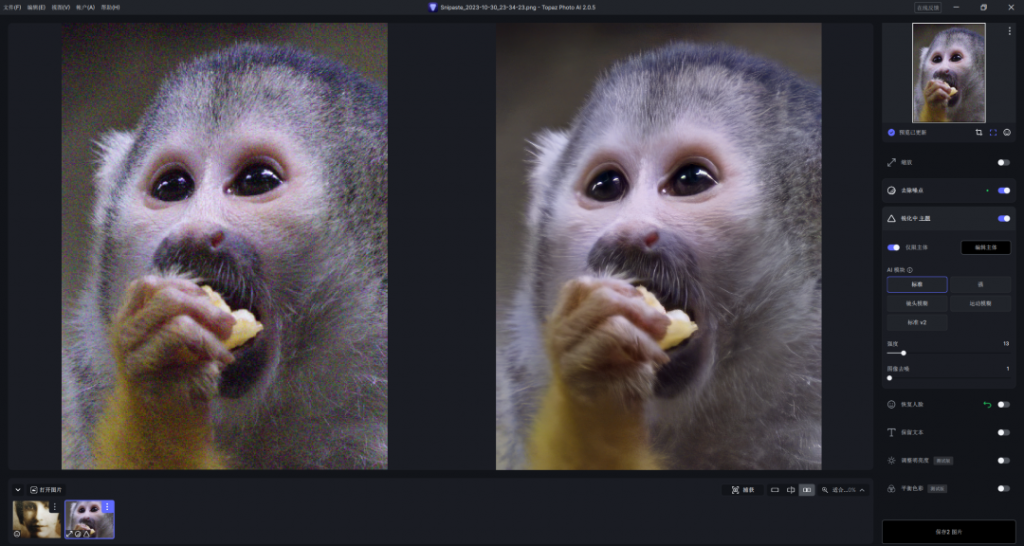

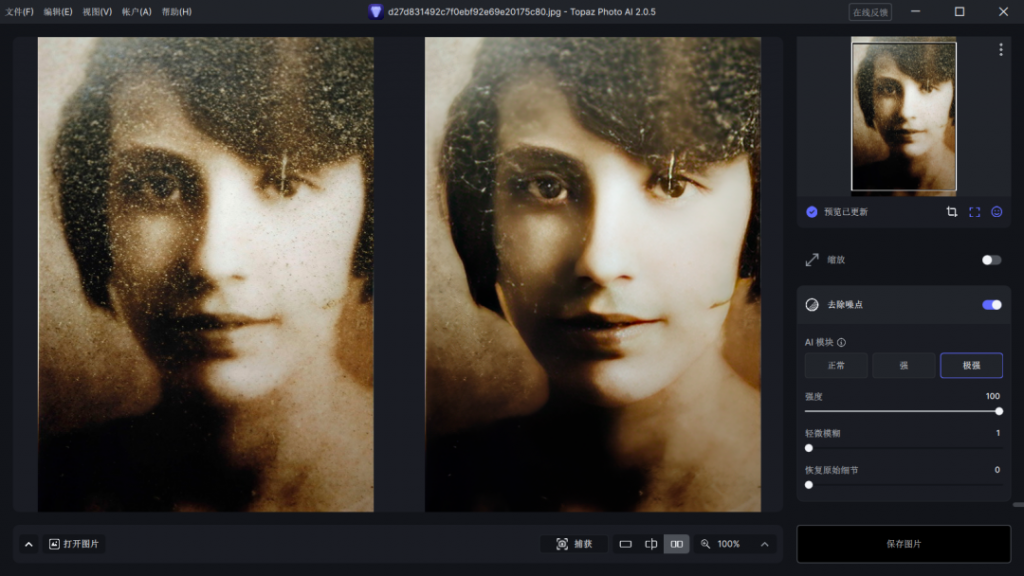

扩散模型(Diffusion models)

生成对抗网络(generative adversarial networks,Gan)是几年前让人工智能生成图像的主流技术之一。这些算法相互对立,一种算法训练生成图像,而另一种算法则对照现实情况检查结果,从而不断改进。

扩散模型 从本质上讲是通过添加噪声破坏训练数据来实现智能,然后再通过逆向该过程来恢复数据。之所以被称为扩散模型,是因为这种基于噪声的学习过程与气体分子扩散的方式如出一辙。

涌现性和可解释性(Emergence & explainability)

涌现现象是指人工智能做出一些意料之外的事情,超出了创造者的意图或程序设计。随着人工智能学习变得越来越不透明,它所建立的联系和模式甚至连它的创造者自己都无法解读,涌现现象更有可能发生。

大众可能会认为,要了解人工智能,需要掀开它的隐喻罩,看看它是如何训练出来的。然而,现代人工智能并不透明,它的工作原理往往隐藏在所谓的 “黑盒”中。因此,尽管设计者可能知道他们使用了哪些训练数据,却不知道它是如何在黑盒中产生联想和预测的。这就是为什么研究人员现在专注于提高人工智能的 “可解释性”——从本质上讲,就是让人工智能的内部运作对人类更加透明和易懂。

大模型(Foundation models)

这是对过去一两年中出现的新一代人工智能的另一种称谓,也称为基础模型,它们能够掌握一系列技能:写作文、写代码、绘画、作曲等。过去的人工智能针对特定任务,通常只擅长一件事,而大模型则具有创造性能力,能将在一个领域学到的信息应用到另一个领域。

幽灵(Ghosts)

我们可能正在进入一个时代,人们可以获得某种形式的数字永生,以人工智能“幽灵”的身份活着。然而,这一发展引发了一系列棘手的伦理问题:一个人死后,谁拥有他的数字版权?如果人工智能版本违背了本人的意愿而存在呢?

幻觉(Hallucination)

有时候,如果你问ChatGPT、Bard、Bing此类人工智能一个问题,它会非常自信地回答。但它的回答可能是错误的。这就是所谓的“幻觉”。这是因为生成式人工智能的工作方式,它不是求助于数据库来查找固定的事实,而是根据它所接受的训练信息做出预测。

工具趋同(Instrumental convergence)

粗略地讲,“工具趋同理论”认为超级智能机器会发展出基本的驱动力,比如寻求确保自身的自我保护,或者发展额外的资源、工具、认知能力帮助它们实现目标。这意味着,即使人工智能被赋予了一个看似良性的优先级任务,它也可能导致意想不到的有害后果。

越狱(Jailbreak)

在出现了一些AI失控案例后,设计师对AI产生的内容进行了限制。让人工智能回答如何做非法或不道德的事情会被拒绝。然而,仍旧有可能通过“越狱”获取答案,需要使用创造性的语言、假设的场景、诡计绕过保护措施。

知识图谱(Knowledge graph)

知识图谱,也被称为语义网络,是一种将知识作为网络来思考的方式,这样机器就可以理解概念是如何关联的。例如,在最基本的层面上,在这样的图表中,猫与狗的联系会比与秃鹰的联系更紧密,因为它们都是有毛和四条腿的家养哺乳动物。

大语言模型(Large language models,LLMs)

大型语言模型是一种先进的人工智能系统,旨在理解和生成类似人类的语言。它利用具有数百万甚至数十亿参数的深度神经网络架构,使其能够从大量文本数据中学习复杂的模式、语法和语义。

模式坍塌(Model collapse)

为了开发最先进的人工智能模型,研究人员需要用庞大的数据集进行训练。最终,随着人工智能产生越来越多的内容,这些材料将反馈到训练数据中。如果期间犯了错误,这些错误可能会随着时间的推移而扩大,最终导致 “模型坍塌”。

神经网络(Neural network)

在研究人工智能的早期阶段,机器是用逻辑和规则来训练的。机器学习的出现改变了这一切。现在最先进的人工智能可以自己学习。这一概念的演变导致了“神经网络”的出现,这是一种机器学习模式,使用相互连接的节点,模仿人类的大脑。

开源(Open-source)

几年前,生物学家意识到,在互联网上公开危险病原体的详细信息可能存在潜在危险,它可能被不法分子利用。

最近,人工智能研究人员和公司也面临着类似的困境:人工智能应该在多大程度上开源?鉴于最先进的人工智能目前掌握在少数几家私营公司手中,一些人呼吁提高这些技术的透明度和民主化。然而,对于如何在开源和安全之间取得平衡,仍存在分歧。

提示工程(Prompt engineering)

人工智能现在在理解自然语言方面表现优异。然而,要想从中获得最好的结果,需要有能力写出有效的“提示词”,即输入的文本很重要。

一些人认为,“提示工程”可能代表着工作技能的新前沿,就像几十年前掌握微软Excel让你更容易被雇佣一样。人们普遍认为,如果你擅长提示工程,你就可以避免被人工智能取代,甚至可能获得高薪。

量子机器学习(Quantum machine learning)

就最大程度的炒作而言,2023年仅次于人工智能的是量子计算。大家都在期望两者的结合。研究人员目前正在积极探索利用量子过程来增强机器学习。谷歌人工智能研究人员称:“在量子计算机上建立的模型可能会强大得多……可能会在更少的数据上实现更快的计算和更好的泛化”。

逐底竞争(Race to the bottom)

随着人工智能的迅速发展,一些研究人员担心,它们可能会在影响方面引发“逐底竞争”。伴随首席执行官和政界人士竞相将公司和国家置于人工智能的前沿,该技术可能会加速发展,以至于无法建立保障措施、适当的监管减轻道德担忧。

强化(Reinforcement)

人工智能相当于狗粮。当人工智能学习时,通过反馈指导其向正确的方向发展。强化学习奖励那些理想的输出,惩罚那些不理想的输出。

超级智能和修格斯(Superintelligence & shoggoths)

超级智能是指远远超过人类心智能力的机器。这超越了“通用人工智能”的范畴,它描述的是一个实体,该实体拥有世界上最聪明的人类思想也无法匹敌的能力。由于人类目前是世界上最聪明的物种,并使用我们的大脑控制世界,那么如果我们创造出比我们聪明得多的东西会发生什么?

一种黑暗的可能性是“带着笑脸的修格斯”:一种噩梦般的、洛夫克拉夫特式的生物,有人认为它可能代表人工智能接近超级智能的真实本质。对我们来说,它是一个和蔼可亲、快乐的人工智能,但其内心深处隐藏着一个怪物,有着与我们完全不同的外星欲望和意图。

训练数据(Training data)

分析训练数据是人工智能在能够做出预测之前进行学习的方式——因此数据集中的内容、数据是否有偏差以及数据有多大都很重要。

无监督学习(Unsupervised learning)

无监督学习是一种机器学习模式,人工智能在没有人类任何明确指导的情况下从未标记的训练数据中学习。

声音克隆(Voice cloning)

只要一分钟的个人讲话音频,一些人工智能工具就能迅速合成一个听起来非常相似的“声音克隆”。

弱人工智能(Weak AI)

过去,研究人员会用特定的规则和启发式方法训练人工智能,让它能玩单一的游戏,比如国际象棋。像这样的人工智能可能非常擅长一项任务,但在其他方面表现不佳,这就是所谓的“弱人工智能”。

未知风险(X-risk)

人工智能会导致人类灭绝吗?一些研究人员和技术专家认为,人工智能已经成为一种“未知风险”,与核武器和生物工程病原体一样,因此其持续发展应该受到监管、限制甚至停止。

YOLO

YOLO是一种目标检测模型,由于其工作速度快,被人工智能图像识别工具广泛使用。

零样本(Zero-shot)

当人工智能给出零样本答案时,这意味着它对以前从未遇到过的概念或对象做出了回应。

所以,举个简单的例子,如果一个被设计用来识别动物图像的人工智能已经被训练过猫和狗的图像,它很难识别马或大象。但是通过零样本学习,它可以利用对马的语义了解,比如腿的数量、缺乏翅膀,来将它的属性与训练过的动物进行比较。