随着科技的飞速发展,人工智能正日益成为推动社会进步的重要力量,其在教育领域的应用与融合更是引发了广泛关注。

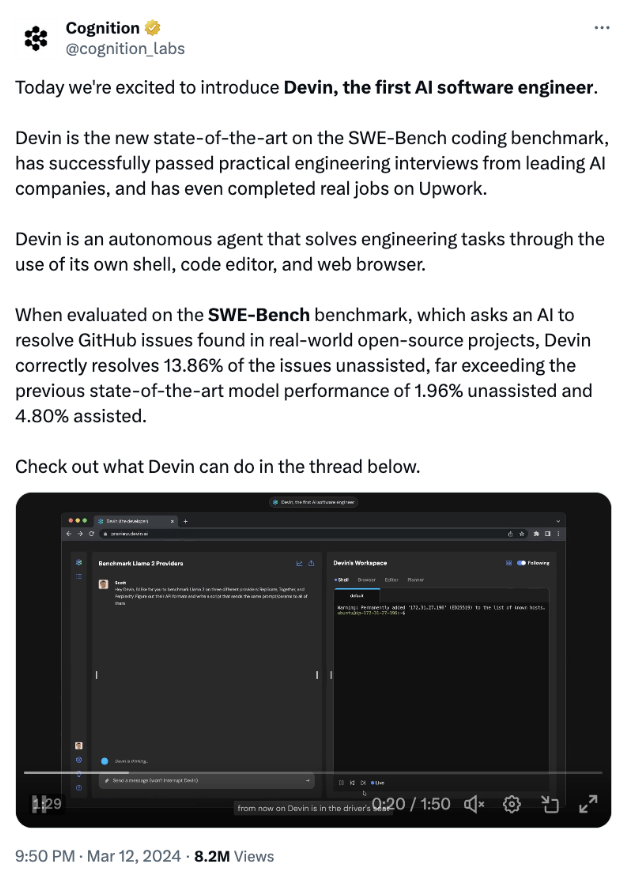

在2024年全国两会的热烈讨论中,人工智能成为代表委员们关注的焦点。

· 关于人工智能,代表委员们都提了什么建议?

· 新时代下的少年儿童要如何应对人工智能带来的机遇与挑战?

今天我们一起来看!

01关于人工智能,代表委员们都提了哪些建议?

本次两会期间,多位代表委员围绕人工智能在教育领域的应用提出了建设性意见和建议。

看点一:民进中央带来了《关于积极推动人工智能赋能教育变革的提案》,建议积极推动生成式人工智能与教育深度融合,走出一条创新驱动、科技向善、持续健康的发展路径。

看点二:在全国人大代表、小米集团创始人雷军看来,未来各行各业对掌握人工智能基本技能的人力需求正急剧增长,加强人工智能领域人才培养,将成为我国产业持续升级的关键因素。

他建议将人工智能纳入教育培养体系,一方面从义务教育阶段普及人工智能素养教育,九年义务教育阶段设置人工智能通识课程,同时将相关内容纳入中小学社会实践活动。

看点三:全国人大代表、重庆市九龙坡区谢家湾教育集团党委书记、总校长刘希娅认为“提升科学运用人工智能的意识和能力,改进学生学习方式,是教育数字化转型的必然要求。”

看点四:全国人大代表、内蒙古呼伦贝尔市海拉尔第二中学教师胡海娟建议,逐步建设和完善科学合理的科学教育管理体系和评价标准,将教师科技培训纳入学校评价机制。将小学、初中、高中科技特长生取得相应国家级、省级成绩纳入升学体制,将科学教育纳入教师职称和各级教育系统教师评优体系。

人工智能带来了哪些挑战?

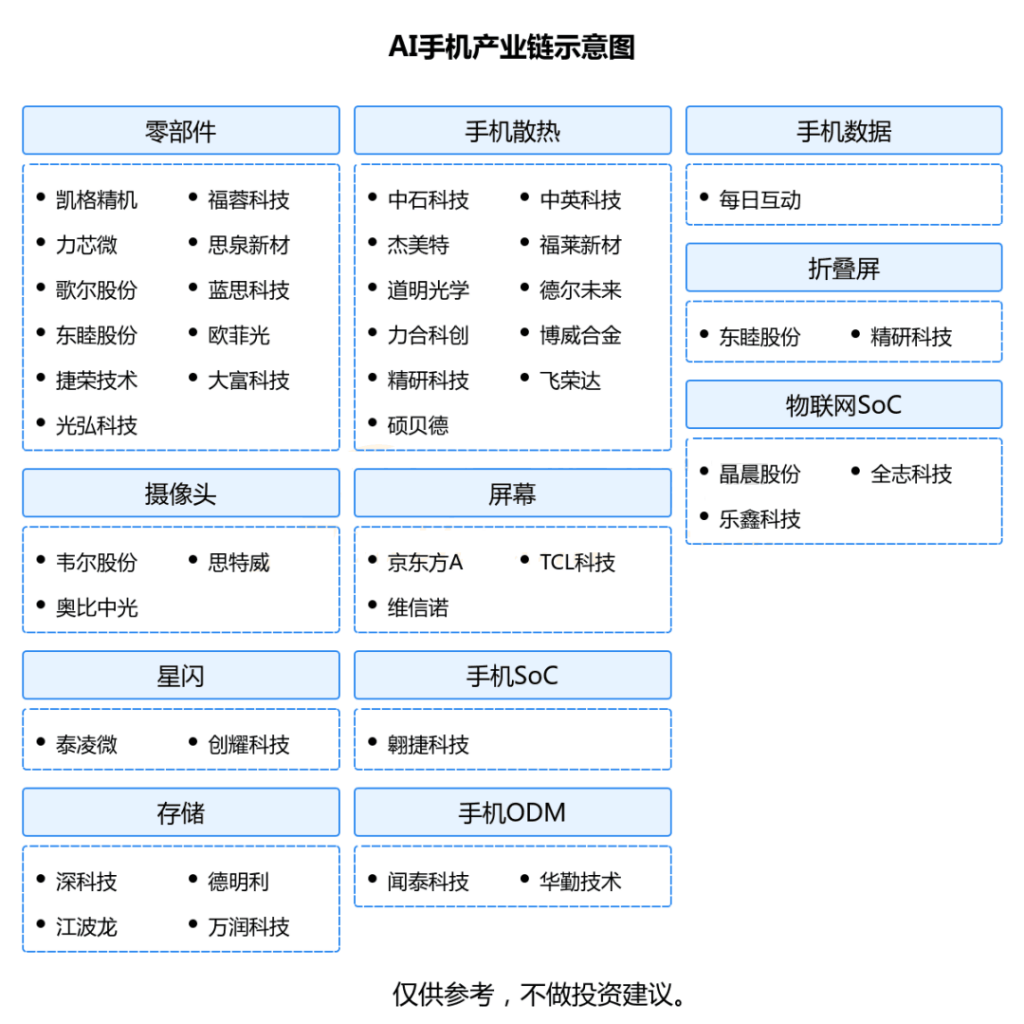

人大代表的提议并非空穴来风,人工智能的突然到来,已经让各个行业都面临着众多问题与巨大的挑战:

比如说人工智能可以在什么产业落地,进化成更好的工具?少年儿童会关心未来的学习方向与专业,是否有所变革?以及生成式AI创作的内容,到底该受什么法律法规保护?

所有的问题不仅仅是成年人需要思考的,也需要让当下的儿童有所感知。面对人工智能带来的未知的挑战,我们务必要做到:

1. 增强儿童数字素养:让孩子杜绝电子产品已经不可能了,这个时代更需要的是培养儿童对人工智能和相关技术的基本理解,让他们了解这些技术如何工作以及它们在日常生活中的应用,这样才能利用人工智能辅助自己获取更好的学习体验。

2. 培养孩子安全意识教育:网络不是法外之地,教育儿童如何安全地使用互联网和人工智能技术,包括隐私保护教育、识别网络欺凌和避免网络诈骗,都是每位父母和老师都需要重视的教育。

3. 创意与创新鼓励:鼓励儿童通过编程、机器学习项目等活动,利用人工智能进行创意和创新的尝试,发挥他们的想象力和解决问题的能力。

4.家长与教师的辅助角色:家长和教师应该共同学习人工智能的知识,以便更好地指导儿童使用这些技术,并理解它们可能带来的影响。

通过这些策略,才能让儿童在人工智能飞速发展下应对可能遇到的挑战,为未来的发展奠定坚实的基础。

人工智能环境下要提升孩子哪些能力?

当然了,随着时代的进步,被动应对倒不如主动学习!

在未来的人工智能环境中,少儿教育的重点应当是培养孩子们适应和利用这一技术变革的能力,为了做到这一点,教育不仅需要注重基础知识的学习,更应侧重于以下几个方面的能力培养:

1. 创新思维能力:在人工智能时代,机器可以处理许多重复性和逻辑性强的任务。因此,创新思维的培养变得尤为重要,它可以帮助孩子们在未来解决那些机器难以应对的复杂问题,这样才能保证不被机器所替代。

2. 问题解决能力:与创新思维相辅相成,问题解决能力的培养能够使孩子们学会如何分析问题、寻找问题的根源,以及设计和实施解决方案,这在与人工智能互动和合作时尤为重要。即使是同样地使用ChatGPT,不同的人提问方式不同也会得到不同的答案,会分析问题、解决问题的人将能利用ChatGPT获得更优质的答案。

3. 数字素养:理解数字世界的运作方式,包括数据的收集、分析和解读,是在人工智能环境中生存和成功的关键。数字素养不仅仅是能够使用技术,更重要的是理解技术背后的原理和逻辑。

4. 伦理和社会责任感:随着人工智能技术的普及,对伦理和社会责任的关注也在增加。培养孩子们的伦理意识和社会责任感,可以帮助他们在未来的人工智能社会中作出负责任的决策。

在强调以上能力的同时,对编程学习的重视成为了自然而然的延伸——编程不仅是实现人工智能的基础技能,更是一种训练逻辑思维、解决问题能力的有效手段。通过编程教育,孩子们不仅可以学会如何控制机器,更重要的是,他们可以学会如何与机器合作,创造出新的解决方案。

因此,编程不仅是孩子们适应未来社会的需要,更是他们在未来人工智能环境中取得成功的关键所在。